Militär, Feuerwehr und Polizei können täglich mit gefährlichen und hochdynamischen Situationen konfrontiert werden, die ein schnelles Handeln erfordern. Unbemannte Systeme, wie Unmanned Aerial Vehicles (UAVs) und Unmanned Ground Vehicles (UGVs), werden zunehmend von den Einsatzkräften genutzt, um in gefährlichen Situationen Aufgaben zu übernehmen und durch ihre Sensoren zusätzliche Informationen zu liefern. Dadurch kann die Sicherheit der Einsatzkräfte sowie die Effektivität und Effizienz des Einsatzes erhöht werden. Meist arbeiten Einsatzkräfte und unbemannte Systeme in einem Team zusammen, das sogenannte Manned-Unmanned Teaming (MUM-T). Für eine gute Zusammenarbeit und bestmögliche Unterstützung der Einsatzkräfte ist es wichtig, dreidimensionale Räume wie das Gelände und Lufträume erfassbar zu machen und die Zusammenarbeit zwischen Einsatzkräften sowie unbemannten Systemen zu koordinieren.

Immersive Darstellung des Einsatzortes

Virtual Reality in der Missionsplanung

Aufgabe

Das Ziel des Projekts AutoAuge (Automatische Augmented Gefechtsfeldaufklärung) ist die Untersuchung der Möglichkeiten, Vorteile sowie die Identifizierung notwendiger Unterstützungen in zukünftigen MUM-T-Einsätzen. Dafür werden nicht einzelne teleoperierte Systeme eingesetzt, sondern Schwärme von unbemannten Systemen im dreidimensionalen Raum, d.h. dem Zusammenspiel aus Boden und Luft. Dabei ist es wichtig, dass die Einsatzkräfte entlastet und nicht in ihrem Auftrag behindert werden.

Entscheidend hierfür ist unter anderem eine gelungene Missionsplanung, welche es den Einsatzkräften erlaubt, ihre Vorgehensweise im Zusammenspiel mit den unbemannten Systemen genau und vorrausschauend zu planen. Der hierfür darzustellende Einsatzraum von MUM-T-Einsätzen besteht aus dreidimensionalen Informationen. Für Drohnen (UAVs) sind beispielsweise Lufträume sowie über dem Boden liegende Wegpunkte relevant. Für Bodenfahrzeuge (UGVs) hingegen ist es wichtig, vorab Informationen zu Höhenunterschieden im Terrain zu haben, welche gegebenenfalls ein Umfahren notwendig machen. Häuser und Wälder müssen bei der Planung mitbedacht werden, da sie sowohl für UAVs als auch für UGVs Hindernisse darstellen können. Im Rahmen von AutoAuge wurde untersucht, wie diese dreidimensionalen Informationen sowie die entsprechenden Planungswerkzeuge gestaltet werden können, um eine bestmögliche Vorbereitung des Einsatzes zu ermöglichen.

Methodik / Lösungsansatz

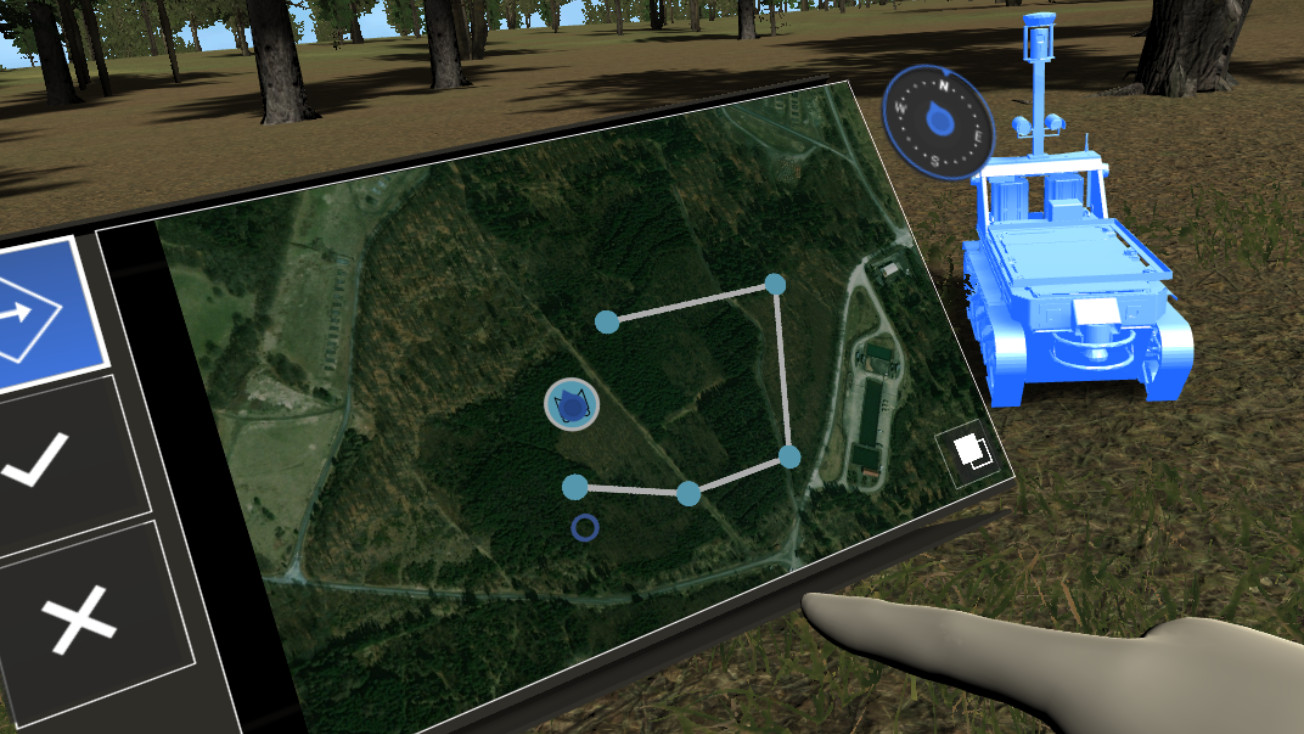

Ziel des Konzepts für die Missionsplanung war eine intuitive Darstellung der dreidimensionalen Informationen, welche die Nutzer in die Lage versetzen den Einsatz mit den unbemannten Systemen am Einsatzort zu planen. Daher wurde die Missionsplanung als Virtual Reality (VR) konzipiert, sodass eine immersive Darstellung des Einsatzortes möglich ist.

Während reale Informationen, wie das Terrain, Bäume und Häuser, so intuitiv erfahrbar gemacht werden, müssen typischerweise zweidimensionale Interaktions- und Planungswerkzeuge in die dreidimensionale Welt übertragen werden. Daher wurde die VR-Missionsplanung in einem iterativen, menschzentrierten Ansatz und im engen Austausch mit den Einsatzkräften stetig weiterentwickelt. Während des Austauschs mit den Einsatzkräften wurden besonders relevante Kernelemente der Nutzerschnittstelle identifiziert und als Forschungsschwerpunkte vertiefend betrachtet.

Zur Planung des Einsatzes wird dem Nutzer als Tablet eine vertraute Metapher an die Hand gegeben. Auf dem Tablet werden eine zweidimensionale Karte und auswählbare Planungswerkzeuge angezeigt. Die Karte kann sowohl als Satellitenansicht als auch als vereinfacht Darstellung angezeigt werden und die Nutzer können sich ein UTM-Gitter ein- oder ausblenden lassen. Für die bessere Orientierung in der virtuellen Welt kann außerdem der selbst zurückgelegte Pfad auf der Karte ein- und ausgeblendet werden. Zusätzlich ist an der oberen, rechten Ecke ein Kompass befestigt.

Die unbemannten Systeme, welche eingesetzt werden sollen, werden sowohl in der dreidimensionalen Umgebung als auch auf der zweidimensionalen Karte angezeigt. In der Karte können die Nutzer Wegpunkte für die unbemannten Systeme anlegen, welche diese daraufhin abfahren bzw. abfliegen. Über die Karte oder in der realen Welt können sich die Nutzer auf eines der unbemannten Systeme teleportieren, sodass sie mögliche Hindernisse und Informationen sehen und die Wegpunkte entsprechend anpassen können.

Als Forschungsschwerpunkte wurden die Fortbewegung in der virtuellen Welt sowie die Interaktion mit Menüs zur Systemkontrolle betrachtet.

Zur Fortbewegung wurde eine neue Teleportationsmethode entwickelt, mittels derer sich Nutzer nicht nur entlang des Terrains sondern auch in die Höhe teleportieren können. Im ersten Schritt wird mittels einer Zeigegeste ein Punkt auf dem Boden ausgewählt. Im zweiten Schritt wird die Höhe über diesem Punkt ausgewählt, indem die Hand nach oben oder nach unten bewegt wird. Eine Säule wird in ein Meter großen Abständen entsprechend der Bewegung vom Boden nach oben gezogen, sodass die Nutzer die Zielposition entsprechend ihrer aktuell Handposition direkt sehen können. Entlang der ein Meter großen Abstände wird die Position über dem Boden sowie über Normalnull angezeigt.

Zur Systemkontrolle wurde ein Kreismenü integriert, das an dem Arm der Nutzer verankert ist und sich auf Knopfdruck am Controller ein- und ausblenden lässt. Die Auswahl der einzelnen Menüpunkte erfolgt mittels der anderen Hand. Als Forschungsschwerpunkt wurden verschiedene Eingabemethoden untersucht: Die Eingabe mittels Zeigegeste, tatsächlichem Drücken mit dem virtuellen Zeigefinger, Rotation des Joysticks des Controllers und mittels Rotation des Handgelenks.

Ergebnis / Ausblick

Das Ergebnis der VR-Missionsplanung im Rahmen des Projekts AutoAuge sind ein Demonstrator sowie mehrere Veröffentlichungen zu Fortbewegungs- und Systemkontrollmöglichkeiten in der virtuellen Realität.

Der Demonstrator zeigt das Potential von VR zur Missionsplanung von MUM-T-Einsätzen. Sowohl während der formativen Nutzerstudie als auch während des Systemtests regten Probanden und Nutzer mehrere potentielle Anwendungsgebiete an. Insbesondere die Möglichkeit, realitätsnahe Visualisierungen potenzieller Einsatzorte aus beliebiger Perspektive nachzuvollziehen, wurde als vielversprechende Funktion hervorgehoben. Eine Ausweitung der Forschung findet bereits in aktuellen Projekten statt: Das Projekt Bewertung des Einsatzes von MikroDrohnen in Soldatensystemen (INSIDE) behandelt die Darstellung von Lageinformation, die von UAVs in Innenräumen aufgenommen werden, mittels Augmented Reality (AR). In dem Projekt Virtuelle Operationszentrale für Unbemannte Systeme (VOPZ UAS) wird die Möglichkeit einer virtuellen Operationszentrale zur Drohnensteuerung in VR betrachtet.

Die Studien zur Fortbewegung sowie Systemkontrolle in VR bilden zudem die Grundlage für weitere Forschungsarbeiten. Zum einen wird untersucht, wie der Prozess zur Gestaltung von Fortbewegungsmethoden in VR auf Basis einer gegebenen Anforderungsmenge unterstützt werden kann. Zum anderen wird die Übertragung traditioneller Desktop-basierter Interaktionstechniken in den dreidimensionalen Interaktionsraum untersucht.

Projektpartner

- Bundesministerium der Verteidigung (BMVg)

- Bundesamt für Ausrüstung, Informationstechnik und Nutzung der Bundeswehr (BAAINBw)

Veröffentlichungen

Mundt, M. & Mathew, T., (2019). Untersuchung von Kreismenüs für die Systemkontrolle in der Virtuellen Realität. In: Alt, F., Bulling, A. & Döring, T. (Hrsg.), Mensch und Computer 2019 - Tagungsband. Association for Computing Machinery, New York, NY, USA. DOI: 10.1145/3340764.3344448

Prinz, L., Kaufeld, M. & Mathew, T., (2019). Point-and-Lift: 3DoF-Fortbewegung in Virtuellen Umgebungen. In: Alt, F., Bulling, A. & Döring, T. (Hrsg.), Mensch und Computer 2019 - Tagungsband. Association for Computing Machinery, New York, NY, USA. DOI: 10.1145/3340764.3344449

Mundt, M. & Mathew, T., (2020). An Evaluation of Pie Menus for System Control in Virtual Reality. In: Proceedings of the 11th Nordic Conference on Human-Computer Interaction: Shaping Experiences, Shaping Society (NordiCHI '20). Association for Computing Machinery, New York, NY, USA, Article 12, 1–8. DOI: https://doi.org/10.1145/3419249.3420146