Zivile Rettungseinsätze oder militärische Operationen in Gebäuden sind für die Einsatzkräfte gefährlich und hoch dynamisch, weil die Sicht durch die Wände enorm eingeschränkt ist. Mikrodrohnen könnten das Risiko verkleinern: Sie können die Einsatzkräfte begleiten, die Lage erkunden und so bereits frühzeitig Gefahren identifizieren, die hinter der nächsten Ecke lauern. Allerdings sind aktuell erhältliche Modelle in erster Linie für den Außeneinsatz konzipiert. Die Nachfrage ist hier schlichtweg größer. Die Möglichkeiten, sie in geschlossenen Räumen oder gar Kanälen einzusetzen, sind sehr begrenzt. Damit sie dennoch hierfür genutzt werden können, müssen die Bedienung und die Darstellung der Informationen möglichst benutzerfreundlich und zuverlässig sein.

Mobile Benutzungsschnittstellen und Augmented Reality für Mikrodrohnen

Reiternavigation

Aufgabe

Anders als unter freiem Himmel können Drohnen in geschlossenen Räumen nicht auf Satellitendaten zurückgreifen. Dies erschwert die autonome Navigation und verlangt alternative Lösungen, die es im Projekt zu entwickeln galt. Darüber hinaus sollten Aspekte identifiziert und bewertet werden, die dazu beitragen, die Mikrodrohnen in den Einsatzkontext zu integrieren. Anhand der daraus abgeleiteten ergonomischen Kriterien sollte eine Benutzungsschnittstelle gestaltet werden, mit der die Drohne gesteuert wird und Informationen angezeigt werden.

Wie Aufklärungsdaten mit Mikrodrohnen in Innen- und Außenbereichen erfasst und gesammelt werden können, wurde in Zusammenarbeit mit der Abteilung »Sensordaten- und Informationsfusion« untersucht.

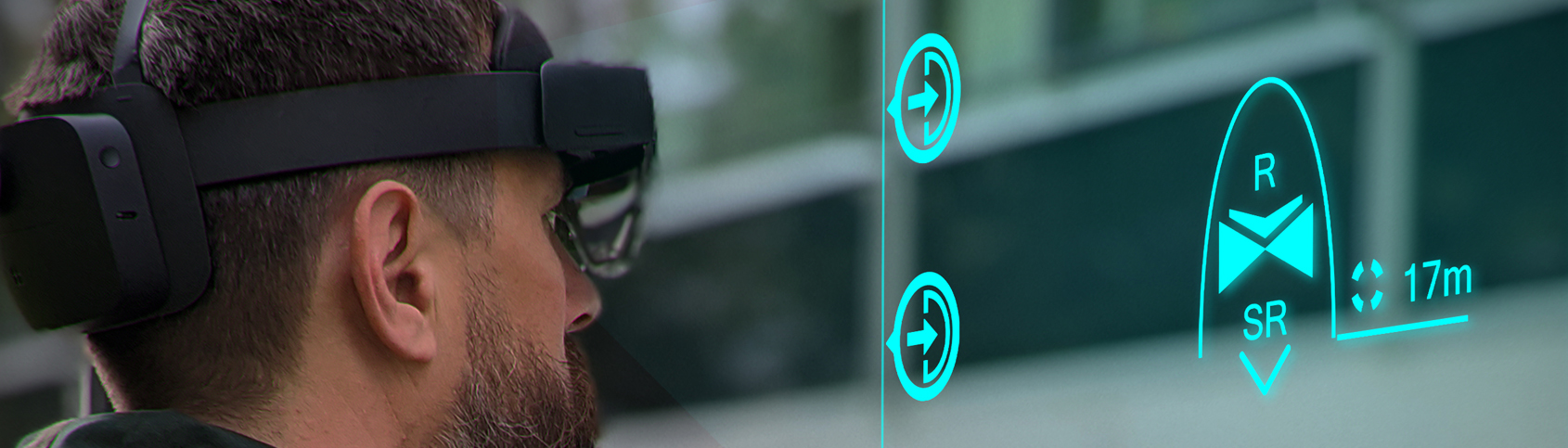

Der Schwerpunkt der Abteilung »Mensch-Maschine-Systeme« lag hierbei darauf, die intuitive Benutzungsschnittstelle zu konzipieren und zu visualisieren. Neben einer mobilen Benutzeroberfläche wurde zudem eine Schnittstelle für Augmented Reality (AR) entworfen und umgesetzt. Besonderes Augenmerk lag auf der Verwendung von multimodaler und situationsbezogener Kommunikation. Wie AR bestmöglich zur Bereitstellung einer räumlichen Darstellung von Informationen eingesetzt werden kann, wurde ebenso untersucht wie der Einsatz verschiedener Modalitäten (Touch, Gesten und Head-Tracking), um Informationen zu explorieren und die Drohne zu steuern.

Methodik / Lösungsansatz

Für die Interaktion mit der Drohne wurden zwei Ansätze verfolgt: zum einen die Nutzung eines mobilen Endgerätes (Smartphone) und zum anderen der Einsatz eines AR-Head-Mounted-Display (HMD). Für die Ausgestaltung beider Schnittstellen wurden im Vorfeld Anforderungen mit potenziellen Nutzern erhoben, die die besondere Unterstützung des Situationsbewusstseins und die kontextspezifische Nutzung in den Blick nahmen.

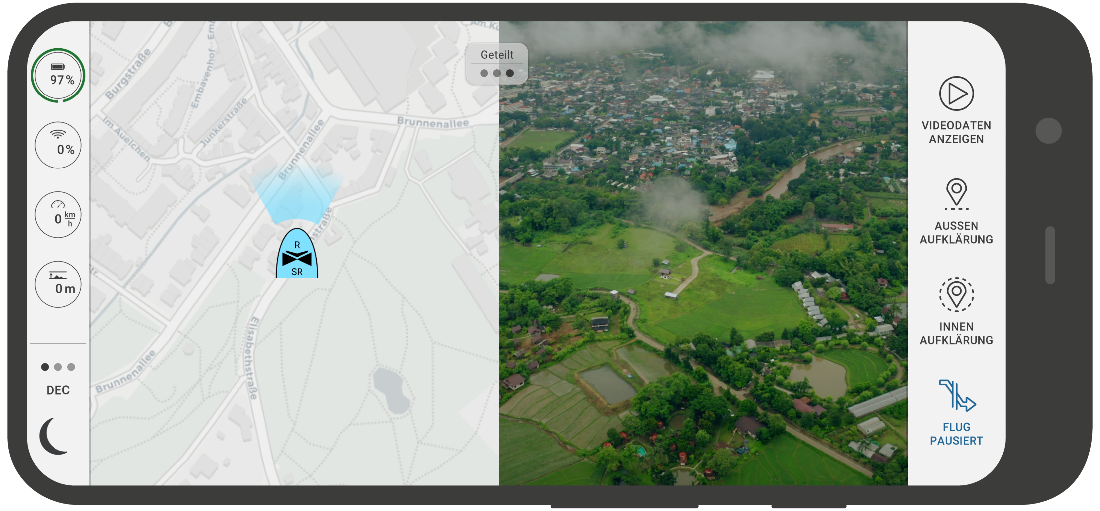

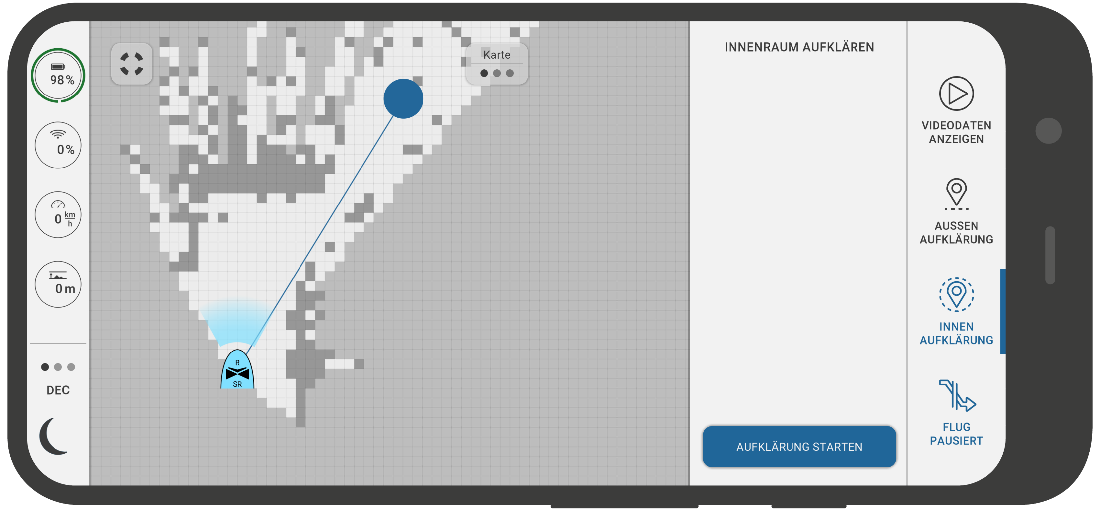

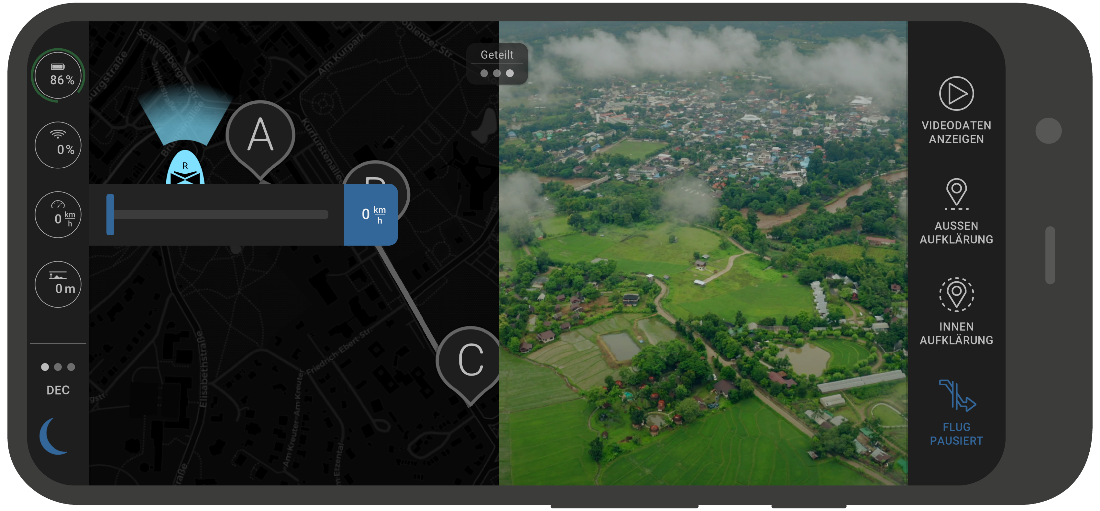

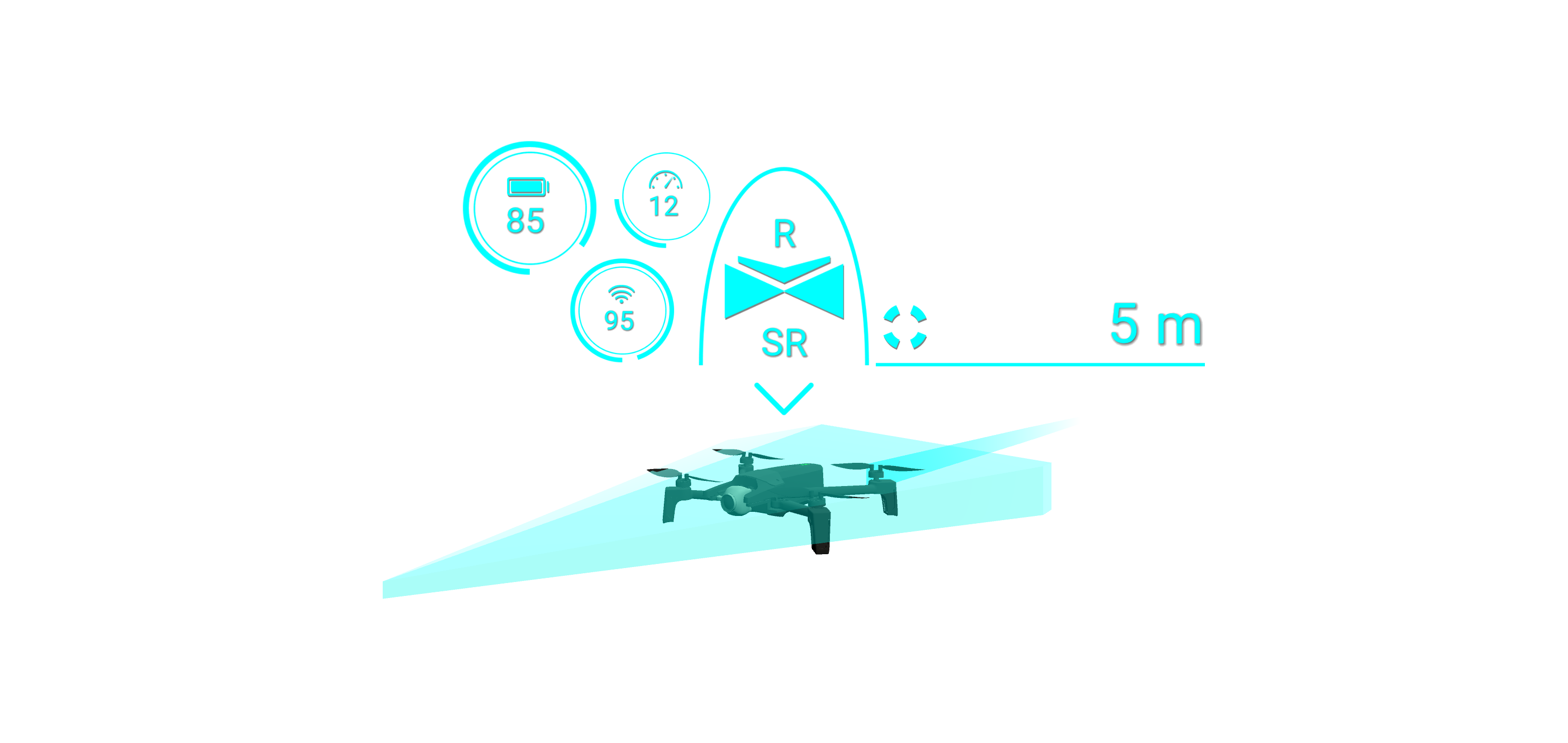

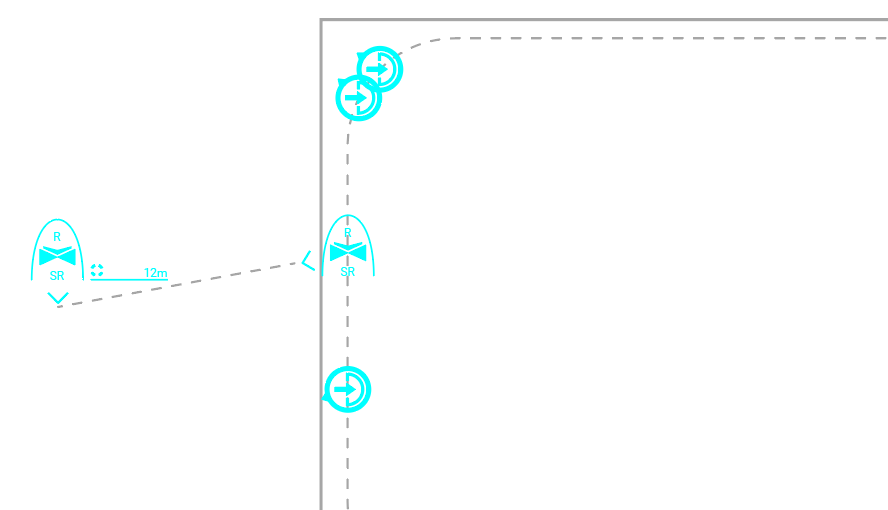

Zentrales Element der mobilen Benutzerschnittstelle ist die Lagedarstellung. Darüber werden sowohl Drohnenbefehle gegeben als auch Lageinformationen von Außen- und Innenbereichen dargestellt. Der Nutzer kann – nach individuellen Vorlieben und aktuellen Erfordernissen der Situation – aus verschiedenen Darstellungsmodi auswählen. Statusinformationen der Drohne werden platzsparend als kombinierte Steuerungselemente umgesetzt und zur intuitiven Erfassung farbig kodiert. Zudem wurden Touch-Gesten für die manuelle Steuerung der Drohne entwickelt und separat getestet. Hierzu wurde ein Simulator für den Einsatz im Außenbereich erstellt, der unter anderem das Höhenprofil der Umgebung realitätsnah darstellt.

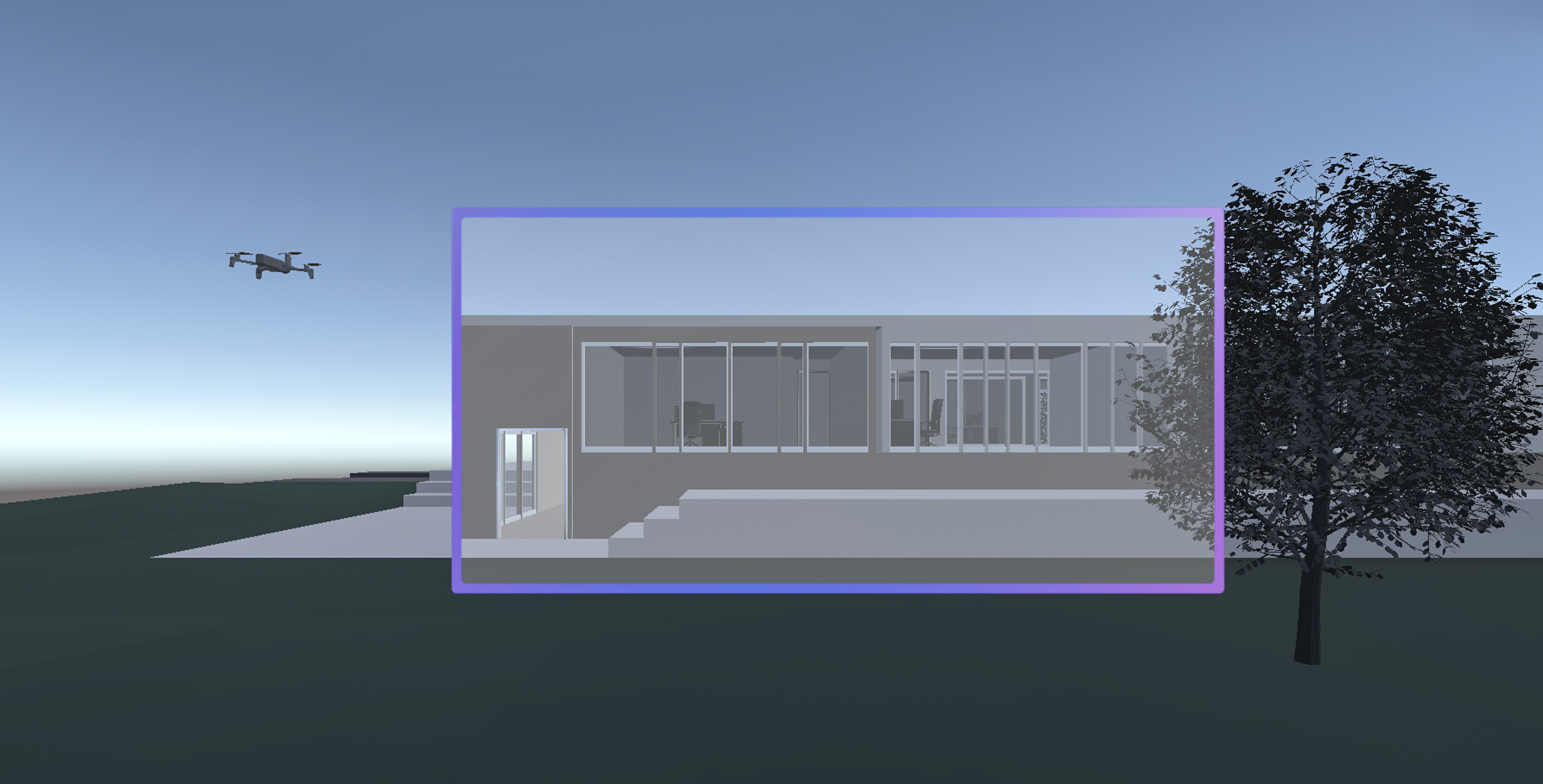

Die AR-Schnittstelle bietet sowohl kontextspezifische Visualisierungen, wie Lageinformationen und Drohnenstatus, als auch Tiefeninformationen. Um die Wirksamkeit verschiedener Strategien für Letztere zu evaluieren, wurde eine Nutzerstudie durchgeführt.

Schließlich entstand eine Simulationsumgebung für die AR-Schnittstelle mittels Virtual Reality. Dies erlaubt einerseits, verschiedene AR-HMDs als Sichtbereiche und Interaktionsmöglichkeiten nachzubilden. Andererseits können Gestaltungslösungen schnell umgesetzt und iteriert werden, ohne sie auf verschiedenen Endgeräten zeitaufwendig installieren zu müssen.

Ergebnis / Ausblick

Die Benutzungsschnittstelle, die auf zwei Endgeräte verteilt ist, wurde nach den Prinzipien der menschenzentrierten Gestaltung entwickelt.

Das Smartphone übermittelte die von der Drohne gesammelten Informationen sowie die Angaben zur Drohne. Zudem kann der Nutzer darüber Steuerbefehle an die Drohne senden. Zudem wurde ein nutzerzentriertes Gestenalphabet entwickelt und basierend auf drei verschiedenen Bewegungserfassungssystemen (Touch-Display, Radar-Sensor und Tiefenkamera) realisiert. Anhand von Experteninterviews mit Nutzern wurde dieses Alphabet verfeinert und angepasst. Mit den gesammelten Touch-Gesten kann die Drohne manuell gesteuert werden.

Das AR-Interface stellt Informationen über die Position und den aktuellen Status der Drohne dar und weist auf Objekte außerhalb des Sichtfelds hin. Die Studie zur Tiefenwahrnehmung hat verschiedene Arten der Darstellung von Tiefe untersucht. In der Studie konnte kein positiver oder negativer Effekt von tiefenkodierten Einfärbungen festgestellt werden. Gitter und Linien hingegen verbesserten den egozentrischen und exozentrischen Schätzfehler, verringerten die Schätzzeit, führten zu einer besseren Leistung und einer geringeren geistigen Anstrengung. Diese Effekte können hauptsächlich auf die Stützlinien zurückgeführt werden, die in die Gitterdarstellungen integriert wurden.